История нейросетей: от математических моделей до современных технологий искусственного интеллекта

Первая математическая модель искусственного нейрона появилась в 1943 году, когда коммерческих компьютеров еще не существовало в помине. Ученые просто моделировали мозг на бумаге и в уравнениях, но именно отсюда история нейросетей и берет свое начало. Фрэнк Розенблатт так перехвалил перцептрон на презентации для ВМФ США, что общественность разочаровалась в идее, когда машина не оправдала завышенных ожиданий. За этим последовала череда забытых открытий, которые ждали своего часа, и тот пробил. Например, метод обратного распространения ошибки изобрели еще в 1970-х, но он стал хитом только в 1980-х.

В статье мы пройдем путь от предыстории до современных достижений, затронем критику, возрождения и актуальные технологии вроде GPT-моделей.

Мозг через призму математики

Все начинается с желания разобраться, как именно работает наш мозг. В 1943 году, когда компьютеров в современном понимании практически не существовало, нейрофизиолог Уоррен Мак-Каллок и молодой логик Уолтер Питтс написали статью с длинным названием «Логическое исчисление идей, относящихся к нервной активности». Они придумали первую математическую модель искусственного нейрона. Это был совсем простой элемент:

- он получал сигналы от других «нейронов» (возбуждающие или тормозящие);

- складывал их с определенными весами;

- и выдавал ответ только в том случае, если сумма превышала порог.

По сути, они доказали, что мозг можно описать как машину, которая считает по строгим правилам. Аппаратно ничего этого тогда реализовать не могли — все оставалось на бумаге и в формулах, но именно эта работа связала нейробиологию, логику и будущие компьютерные технологии. Так появилась основа всех современных ИИ — множество простых элементов, связанных между собой, где сложное поведение рождается из элементарных правил.

«Марк-1»: прадедушка нейросети

В конце 1950-х годов американский психолог и инженер Фрэнк Розенблатт решил превратить теорию Мак-Каллока и Питтса в реальную работающую машину. Он придумал перцептрон — первую практическую искусственную нейронную сеть, которая могла не просто считать по формулам, а учиться на примерах. Розенблатт работал в Корнеллской аэронавтической лаборатории и получал деньги от ВМС США. Военные надеялись, что такая машина сможет автоматически читать радары или распознавать цели.

В 1958 году он опубликовал теорию перцептрона, а уже в 1960-м построил настоящий аппарат под названием Mark-1 Perceptron. Это была большая машина размером с комнату.

Как это работало на практике? Представьте: вы показываете машине карточку с нарисованной буквой или простым геометрическим узором. Свет от карточки проходил через линзу и попадал на матрицу из 400 фотоэлементов. Каждый из них выдавал сигнал, который умножался на свой вес (положительный или отрицательный). Все сигналы суммировались, и если сумма превышала порог, машина говорила «да, это объект класса А», если нет — «это класс Б».

Главное волшебство было в обучении. Если машина ошибалась, оператор нажимал кнопку «правильно/неправильно», и специальный механизм автоматически менял веса: усиливал те связи, которые вели к правильному ответу, и ослаблял те, что мешали. За несколько десятков показов одной и той же буквы машина начинала узнавать ее почти без ошибок, даже если букву немного поворачивали или сдвигали.

Это был первый в мире пример настоящего машинного обучения, реализованный не в программе, а в железе. Никаких жестких правил типа «если угол такой-то, то это буква А» — машина сама находила закономерности в данных. Розенблатт с энтузиазмом показывал Mark-1 журналистам. В 1958 году даже The New York Times написала, что перцептрон — это «зародыш электронного компьютера, который, как ожидается, сможет:

- ходить;

- говорить;

- видеть;

- писать;

- воспроизводить себя;

- и даже осознавать свое существование».

Конечно, ожидания были сильно завышены, но сама идея оказалась прорывной. Mark-1 стал настоящим прадедушкой всех современных технологий: он показал, что простая сеть из «нейронов» с изменяемыми весами действительно может учиться распознавать образы без детального программирования. Это вдохновило целое поколение исследователей и заложило основу для всего, что мы сегодня называем искусственным интеллектом.

Что такое персептрон и как он работает?

Перцептрон — самая простая модель искусственной нейронной сети, которую придумал Фрэнк Розенблатт в 1958 году. По сути, это один-единственный искусственный нейрон, который пытается имитировать, как работает настоящий нейрон в мозге, но в сильно упрощенном виде. Он был создан как базовый строительный блок для более сложных сетей. Смоделируем ситуацию, в которой работает перцептрон.

- Получает на вход несколько чисел (например, яркость пикселей на черно-белом изображении).

- Взвешивает каждое из них.

- Складывает и решает: да или нет.

Это идеально подходит для задач классификации: «это буква А или не А?», «кошка на фото или собака?», но только если классы можно разделить прямой линией или плоскостью в многомерном пространстве.

Самое интересное — обучение. Перцептрон учится без учителя, который пишет код правил. Вместо этого используется простое правило Розенблатта.

- Показываем пример с известным правильным ответом.

- Если перцептрон угадал, ничего не меняем.

- Если ошибся:

- a. Если сказал 1, а должно быть 0, уменьшаем веса тех входов, которые были активны (1).

- b. Если сказал 0, а должно быть 1, увеличиваем веса активных входов.

- Шаг изменения весов обычно небольшой, чтобы не «перепрыгнуть» правильное решение.

За много повторений таких корректировок перцептрон постепенно «настраивается» и начинает правильно классифицировать новые примеры. Его главные плюсы:

- очень простой в своем устройстве;

- быстро учится;

- гарантированно находит решение, если данные линейно разделимы.

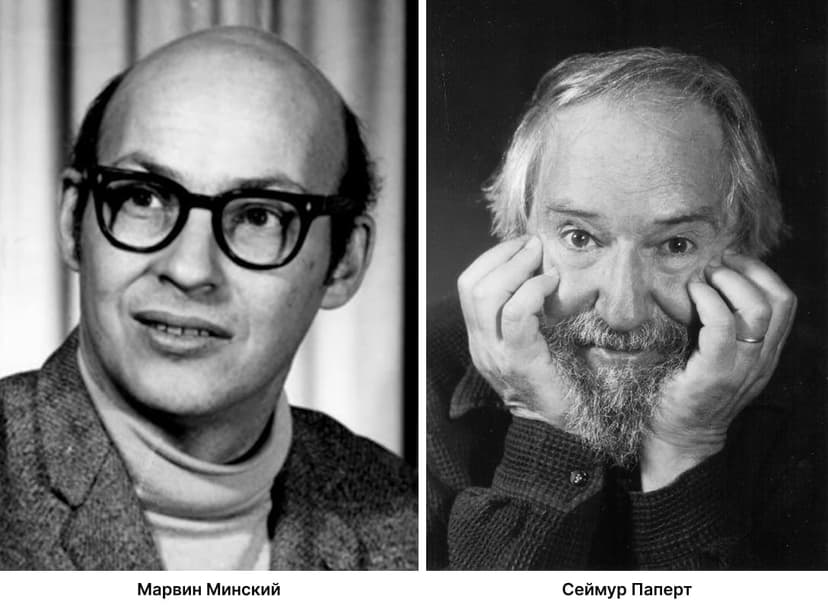

Минусы: абсолютно беспомощен на задачах, где классы нельзя разделить прямой линией. Классический пример — логическая операция. Именно это ограничение в 1969 году показали Минский и Паперт, что сильно затормозило развитие индустрии на долгие годы.

Сегодня однослойный перцептрон почти не используется сам по себе, но его идеи лежат в основе всех современных нейронных сетей: веса, суммирование, активация и обучение по ошибке. Это как первый велосипед в мире машинного обучения – простой, но открыл дорогу всему остальному.

Критика искусственного интеллекта

В конце 1960-х годов ИИ, казалось, были на пике популярности, но все изменилось с выходом книги «Перцептроны» в 1969 году. Ее написали два выдающихся ученых – Марвин Минский и Сеймур Паперт, работавшие в Массачусетском технологическом институте. Их труд стал настоящим ударом по перцептрону и всей области искусственного интеллекта. Они не просто критиковали, они математически доказали, что однослойные модели, такие как перцептрон Фрэнка Розенблатта, имеют серьезные ограничения.

Самый известный пример — простая логическая операция: если один из двух входов равен 1, выход должен быть 1, но если оба входа 0 или оба 1 — выход 0. Звучит несложно, но перцептрон не мог ее решить, потому что данные нельзя разделить одной прямой линией. Минский и Паперт показали, что однослойные сети принципиально не справляются с такими задачами, требующими учета комбинаций входов.

Но их критика пошла дальше. Они предположили, что многослойные сети тоже будут проблемными. На тот момент никто не знал, как эффективно обучать такие сети, и Минский с Папертом намекнули, что это может быть слишком сложно или даже невозможно. Они не говорили, что ИИ бесполезны, но их скептицизм был воспринят как приговор.

Последствия были драматичными. Книга вышла в тот момент, когда разработки и так балансировали на грани популярности и разочарования. После громких обещаний Розенблатта, что перцептроны скоро будут «видеть, говорить и думать», реальность оказалась скромнее. Финансирование исследований резко сократилось, особенно в США. Правительственные гранты и военные контракты, которые поддерживали проекты вроде Mark-1, практически иссякли. Многие ученые покинули область, переключившись на другие направления ИИ или вообще уйдя из науки.

Так началась первая «зима искусственного интеллекта» — период, когда индустрия считалась чуть ли не научным тупиком в принципе. В 1970-х годах интерес к ним угас, и большая часть сообщества ИИ сосредоточилась на разработке систем, основанных на правилах и логике, которые казались более предсказуемыми и понятными. Лишь немногие энтузиасты, вроде Джеффри Хинтона, продолжали верить в потенциал нейронных сетей, работая в тени скептицизма.

Книга «Перцептроны» часто критиковалась за то, что ее выводы преувеличили слабости механизмов. Позже выяснилось, что многослойные сети все-таки можно обучать, и ограничения однослойных перцептронов не распространяются на более сложные архитектуры. Но в тот момент голоса Минского и Паперта, как авторитетных экспертов, перевесили, и идеи ИИ надолго ушли на второй план. Эта «зима» показала, как сильно научный прогресс зависит от веры, денег и общественного настроения.

Эпоха Возрождения нейросетей

После долгой «зимы» искусственного интеллекта в 1970-х, когда почти все отвернулись от ИИ, в 1980-х годах случился настоящий ренессанс. Главным героем этого возвращения стал метод обратного распространения ошибки. Это простой, но гениальный алгоритм, который наконец-то позволил эффективно обучать многослойные нейронные сети.

Идея не была совсем новой. Еще в 1970 году Пол Вербос в своей докторской диссертации описал нечто очень похожее, но его работа осталась почти незамеченной. Позже, в середине 1980-х, алгоритм независимо переоткрыли и популяризировали несколько групп ученых. Самая известная публикация – статья 1986 года Дэвида Румельхарта, Джеффри Хинтона и Рональда Уильямса. Именно она разлетелась по научному сообществу и стала отправной точкой возрождения.

Представьте многослойную сеть: входной слой, несколько скрытых и выходной. Вы подаете пример, сеть выдает ответ, и он оказывается неправильным. Раньше проблема была в том, как понять, какой именно нейрон в каком слое виноват в ошибке. Ведь скрытые слои не имеют прямого «правильного ответа» — их вклад косвенный. Метод обратного распространения ошибки решает этот вопрос.

- Сначала сеть делает прямой проход. Сигнал идет от входа к выходу, каждый нейрон считает взвешенную сумму и применяет функцию активации.

- На выходе мы сравниваем предсказание с реальным ответом и вычисляем ошибку, например, разницу квадратов.

- Потом ошибка «распространяется назад». Начиная с выходного слоя, мы считаем, насколько каждый нейрон предыдущего слоя повлиял на эту ошибку.

- Каждый вес корректируется на маленький шаг в сторону уменьшения ошибки.

- Процесс повторяется слой за слоем назад до самого входа.

Сеть стала понимать, какой вклад в ошибку внес каждый отдельный вес, даже в глубоких слоях. Благодаря данному методу многослойные сети начали показывать реальные результаты:

- распознавать рукописные цифры;

- предсказывать последовательности;

- решать задачи, которые раньше были недоступны.

Энтузиазм вернулся, финансирование потекло снова, а молодые исследователи получили площадку для экспериментов. Этот период 1980-х – начала 1990-х часто называют эпохой возрождения. Он доказал, что критика Минского и Паперта касалась только однослойных перцептронов, а многослойные сети с правильным методом обучения способны на гораздо большее. Именно тогда заложили фундамент для всего того, что мы сегодня называем глубоким обучением.

Затишье перед бурей

Казалось бы, после возрождения в 1980-х технологии должны были рвануть вперед, но в 1990-х и начале 2000-х годов наступило новое затишье — вторая «зима искусственного интеллекта». Энтузиазм угас, и многие исследователи снова отвернулись от нейронных сетей. Произошло это по нескольким причинам.

- Вычислительные мощности того времени просто не тянули глубокие сети. Чтобы обучить сеть хотя бы с несколькими скрытыми слоями на реальных данных, требовались недели или месяцы счета на обычных процессорах. Компьютеры были медленными, памяти мало, а датасетов больших почти не существовало – интернет только начинал развиваться, и собирать миллионы помеченных изображений или текстов было нереально.

- Появились сильные конкуренты. Самый яркий пример – машины опорных векторов (SVM), которые в 1995 году популяризировал Владимир Вапник вместе с Кортесом. SVM работали быстрее, давали отличные результаты на небольших датасетах, имели строгую математическую теорию и не требовали такого тонкого подбора гиперпараметров. Многие задачи классификации и регрессии решались ими проще и надежнее.

- ИИ страдал от переобучения. Без современных приемов вроде добавление слоев часто ухудшало результат, а не улучшало. Исследователи разочаровывались.

- Финансирование опять сократилось. Крупные компании переключились на более «надежные» методы. Многие молодые ученые, видя, что гранты идут в другие степи, выбирали именно эти направления. Джеффри Хинтон позже шутил, что в те годы его и его студентов называли «той странной сектой, которая все еще верит».

Но это затишье было ненапрасным. Оно стало подготовкой к настоящему взрыву. Ведь параллельно происходило несколько важных вещей:

- интернет бурно рос, и начали появляться огромные объемы данных: миллионы изображений, текстов, видео;

- видеокарты становились все мощнее, выпускались новые поколения чипов, изначально для игр, но с тысячами параллельных ядер — идеально для матричных вычислений;

- появились открытые библиотеки и фреймворки.

Кроме того, накопился опыт, люди лучше понимали, как бороться с переобучением. Все это создавало почву для прорыва.

Прорыв: предпосылки и переломные моменты

К началу 2010-х годов три главных ингредиента: большие данные, мощные GPU и улучшенные алгоритмы, наконец сошлись. Затишье закончилось, и началась эра глубокого обучения, которая изменила все. Те, кто не бросил идеи ИИ в трудные времена, оказались в нужном месте в нужный час.

Метод опорных векторов

В 1990-х годах, когда концепции ИИ снова ушли в тень, на первый план вышла мощная альтернатива — метод опорных векторов, или SVM. Это был один из самых популярных и эффективных способов решать задачи классификации и регрессии до прихода эры глубокого обучения.

Представьте две группы точек на плоскости: красные и синие. Обычный классификатор мог бы провести между ними любую линию, лишь бы точки не пересекались. А SVM ищет именно ту гиперплоскость, которая оставляет максимальное свободное пространство с обеих сторон. Это пространство называется «маргин», и чем оно шире, тем лучше, потому что новая точка с большей вероятностью попадет в правильную зону. Что еще делало SVM крутыми в свое время:

- отличная работа на небольших и средних наборах данных;

- хорошая устойчивость к переобучению;

- если данные нельзя разделить прямой линией, SVM незаметно переносит их в пространство более высокой размерности, где разделение становится линейным;

- строгая математическая основа позволяла доказывать свойства и давала уверенность в результате.

В 1995 году Владимир Вапник и Коринна Кортес опубликовали версию с мягкой маржей, которая позволяла допускать небольшие ошибки на сложных данных. Это сделало метод еще практичнее. SVM быстро завоевали любовь в самых разных областях:

- распознавание текста;

- биоинформатика;

- обнаружение спама;

- финансовая аналитика.

Но у SVM были и ограничения. При росте объема данных обучение сильно замедлялось. Плюс подбор правильного ядра и параметров превращался в настоящее искусство. В 2010-х появились огромные датасеты, и SVM начали сдавать позиции.

Сегодня метод опорных векторов все еще используется в нишевых задачах, где данных мало, а точность критична (например, в медицине или финансах), но в большинстве случаев его вытеснили нейронные сети.

Победа на конкурсе ImageNet

В 2012 году сеть AlexNet (от Алекса Крижевски, Ильи Суцкевера и Джеффри Хинтона) выиграла ImageNet, снизив ошибку с 26% до 15%. Глубокая сверточная архитектура с ReLU, dropout и GPU-обучением доказала превосходство глубокого обучения в компьютерном зрении. Это ознаменовало начало современной эры ИИ.

Нейросеть сегодня: GPT-3 и Deep Learning

Сегодня ИИ везде — от рекомендаций до генерации текста. Модели вроде GPT-3 (2020) с 175 миллиардами параметров генерируют текст, код и даже искусство.

Технологии из мира фантастики: генеративный трансформер

Технология «трансформер» появилась в 2017 году и буквально перевернула весь мир обработки естественного языка.

Все началось со статьи группы исследователей из Google под названием «Attention Is All You Need». Авторы предложили полностью новую архитектуру нейронной сети, которая отказалась от старых рекуррентных слоев, использовавшихся для работы с последовательностями вроде текста или речи.

Ключевая идея — механизм внимания. Простыми словами: когда модель читает предложение, она не обрабатывает слова по очереди слева направо, как человек. Вместо этого каждое слово сразу «смотрит» на все остальные слова в предложении и решает, насколько они важны для понимания текущего контекста.

Представьте, что вы читаете фразу: «Кот, который сидел на коврике, мяукнул». Слово «мяукнул» должно понять, что подлежащее — именно «кот», а не «коврик». Механизм внимания мгновенно вычисляет связи между словами, независимо от того, насколько далеко они стоят друг от друга. Это решило давнюю проблему рекуррентных сетей – они плохо справлялись с длинными зависимостями, потому что информация «затухала» по мере прохождения через слои. Перечислим главные преимущества трансформера:

- Параллельность. Все слова обрабатываются одновременно, а не последовательно. Обучение ускорилось в десятки раз.

- Масштабируемость. Чем больше данных и параметров, тем лучше результат.

- Двусторонний контекст. Модель видит весь текст сразу.

Трансформер состоит из двух основных частей: энкодера для понимания текста и декодера для генерации. Но настоящую революцию произвели генеративные модели на основе только декодера, такие как GPT.

GPT-1 вышел в 2018 году, GPT-2 в 2019-м уже шокировал всех способностью генерировать длинные тексты, а GPT-3 в 2020-м с 175 миллиардами параметров показал, что модель может решать десятки задач без специального обучения, просто на основе подсказки. Генеративные трансформеры научились не только тексту: добавив подходящие токены, их используют для генерации:

- изображений;

- музыки;

- видео;

- и даже белковых структур в биологии.

По сути, трансформер стал универсальным строительным блоком современного ИИ. Он позволил масштабировать модели до триллионов параметров, обучать их на огромных объемах интернета и получать результаты, которые раньше казались невозможными.

Что такое Deep Learning?

Deep Learning — направление в машинном обучении, которое использует нейронные сети с большим количеством слоев. В отличие от классического машинного обучения, где инженеры вручную придумывали признаки для данных, глубокое обучение позволяет сети самой автоматически находить и извлекать эти признаки из сырых данных.

Простыми словами, представьте, что вы показываете сети тысячи фотографий кошек и собак. В традиционном подходе вам пришлось бы самому описать, что такое «уши», «хвост», «шерсть» и написать правила. В этом подходе сеть сама учится этому шаг за шагом через слои. Раньше на создание признаков уходили месяцы работы специалистов, теперь сеть делает это сама и часто лучше человека. Сегодня глубокое обучение лежит в основе почти всех впечатляющих достижений ИИ:

- распознавание изображений и видео;

- перевод речи в текст и обратно;

- генерация текста, изображений, музыки;

- автономные автомобили, медицинская диагностика, рекомендации Netflix и YouTube.

Но есть и минусы. Сети требуют огромных ресурсов, плохо объясняют свои решения и могут переобучаться без правильной настройки.

Будущее нейросетей

Мы стоим на пороге действительно впечатляющих изменений в мире. То, что еще недавно казалось далекой перспективой, уже превращается в реальные продукты и исследования.

Самое заметное направление — мультимодальные модели. Уже сегодня мы видим системы, которые одновременно понимают:

- текст;

- изображения;

- аудио;

- и даже видео.

В ближайшие годы это станет стандартом. Одна модель будет принимать голосовую команду, смотреть на фото, анализировать текст и выдавать ответ в желаемом формате. Представьте личного помощника, который не только слышит вас, но и видит ваш экран, понимает жесты и контекст окружающей среды. Такие модели изменят интерфейсы.

Второе важное направление — энергоэффективность и масштабирование. Обучение моделей с триллионами параметров требует огромных дата-центров и потребляет электроэнергии как целый город. Поэтому активно развиваются новые архитектуры, где активируется только часть параметров под конкретную задачу. Цель — сделать мощный ИИ доступным даже на смартфоне или встраиваемых устройствах без облака.

Этичный и безопасный ИИ выходит на первый план. Регуляторы требуют:

- прозрачности;

- отсутствия предвзятости;

- механизмов контроля.

Компании все больше вкладываются в понимание того, как сделать так, чтобы супермощные модели следовали человеческим ценностям и не причиняли вреда.

Интеграция в реальный мир ускоряется. И это сложно не заметить.

- Медицина. Технологии уже помогают диагностировать рак по снимкам лучше врачей, предсказывать структуру белков, подбирать персонализированное лечение. Впереди виртуальные клинические испытания и ИИ-ассистенты в операционной.

- Автономный транспорт. Алгоритмы учатся предсказывать поведение пешеходов и водителей в сложных сценариях.

- Наука. Модели помогают открывать новые материалы, решать уравнения физики, генерировать гипотезы. Уже есть случаи, когда ИИ самостоятельно предложил новые математические теоремы.

Самый обсуждаемый вопрос — путь к искусственному общему интеллекту, способному решать любые интеллектуальные задачи на уровне или выше человека.

FAQ

Когда впервые возникла идея нейросетей?

В 1943 году с модели Мак-Каллока-Питтса.

Кто создал первую нейросеть и что это было?

Фрэнк Розенблатт в 1958–1960 – перцептрон и «Марк-1».

Какие ключевые прорывы произошли в истории нейросетей?

Модель 1943, перцептрон 1958, метод обратного распространения ошибок 1980-е, AlexNet 2012, трансформеры 2017.

Что такое перцептрон?

Простая сеть для классификации с обучением по ошибкам.

Что сегодня считается отправной точкой современной истории нейросетей?

Победа AlexNet на ImageNet в 2012.

Что такое глубокое обучение?

Обучение многослойных сетей для автоматического извлечения признаков.

Способны ли нейросети заменить человеческий мозг?

Нет, они имитируют аспекты, но лишены сознания и творчества; дополняют человека.

Сегодня ИИ — это уже не лабораторная экзотика, а основа технологий, которые реально меняют мир: помогают врачам раньше находить рак на снимках, генерируют реалистичные изображения и текст, управляют рекомендациями в стримингах и даже пишут код. Мой совет: не просто читайте про историю нейросетей — попробуйте сами. Загрузите открытую модель вроде Llama 3 или Mistral, запустите через Ollama или LM Studio на своем компьютере и поиграйтесь. Сгенерируйте историю, напишите код, попросите объяснить сложную тему. Это лучший способ по-настоящему понять их силу и ограничения.

А вы уже пробовали работать с ИИ, генерировали текст, изображения или, может, даже музыку? Поделитесь в комментариях своим опытом – что понравилось, что удивило, а что разочаровало – и, конечно, жду ваших мыслей о том, как вы видите будущее ИИ через 5–10 лет, давайте обсудим!

Комментарии к статье

Пока нет комментариев. Будьте первым!