Как обучаются нейросети: принципы, методы и практика глубокого обучения

Архитектура обучения нейросети

Если представить ИИ как огромный многоэтажный мозг, то ее архитектура — это одновременно и каркас здания, и система лифтов, по которым информация поднимается с этажа на этаж. Каждый уровень обрабатывает данные по-своему.- Нижние слои ловят простые детали, вроде линий, углов или базовых цветов на изображении.

- Средние собирают из них более сложные элементы: контуры, текстуры, формы.

- Верхние уже формируют высокоуровневые концепции: это кошка, это улыбающееся лицо или это дорожный знак «стоп».

- сеть смотрит на пример;

- делает предсказание;

- сравнивает с правильным ответом;

- корректирует веса, чтобы в следующий раз ошибка была меньше.

Это похоже на то, как скульптор постепенно отсекает лишнее от камня. Шаг за шагом модель становится все точнее и универсальнее.

Что в основе?

В основе обучения лежит корректировка весов связей между искусственными нейронами на основе анализа ошибок предсказаний. Это принцип, который работает во всех нейронных сетях — от самых простых до гигантских современных моделей.- Сначала подаю тысячи изображений: вот седан с четырьмя колесами, закрытым кузовом, багажником и прямоугольными фарами, а вот байк с двумя колесами, открытым сиденьем, высоким рулем и круглыми фарами.

- Модель разбивает картинку на пиксели, каждый пиксель или группа пикселей становится входом.

- Она присваивает веса разным признакам: высокому весу для «четыре колеса в ряд», отрицательному для «открытое сиденье».

- Выдает вероятность: «Это автомобиль на 80%».

- количество колес;

- форма кузова;

- наличие крыши.

Многослойность

Многослойность позволяет сети обрабатывать информацию иерархически: каждый следующий слой извлекает все более сложные и абстрактные признаки из того, что передал предыдущий. Это ключевое отличие глубоких ИИ от простых плоских моделей, которые мы разбирали раньше. На практике это выглядит так:- первый слой может научиться реагировать на простые элементы: горизонтальные и вертикальные линии, края, базовые цвета;

- второй слой уже комбинирует их в углы, дуги, текстуры;

- третий собирает из этого круги, прямоугольники, узнаваемые формы;

- дальше идут слои, которые видят глаза, нос, рот. В итоге на верхнем уровне сеть понимает, что перед ней человеческое лицо, причем улыбающееся и принадлежащее конкретному человеку.

Как устроено глубокое обучение нейросети?

Глубокое обучение — это подход машинного обучения, использующий многослойные нейронные сети с десятками, сотнями и даже тысячами слоев для автоматического извлечения признаков из сырых данных без ручного вмешательства инженера. В отличие от классического машинного обучения, где человеку приходилось самому придумывать и кодировать признаки, например, для распознавания кошек на фото выделять «ушки-треугольники», «усы», «шерсть», глубокое обучение позволяет сети самой учиться этим признакам слой за слоем.Процесс работает так: сырые данные, т. е. пиксели изображения, слова текста, звуковые волны, подаются на входной слой. Затем информация проходит через цепочку скрытых слоев. Каждый нейрон в слое получает сигналы от предыдущего, умножает их на свои веса, суммирует и пропускает через функцию активации. Результат передается дальше.

Обучение происходит через обратное распространение ошибки:

- сеть делает предсказание;

- сравнивает его с правильным ответом;

- вычисляет, насколько каждый вес повлиял на ошибку;

- слегка корректирует миллионы параметров в сторону уменьшения ошибки.

Что такое веса нейросети?

Веса — это числовые параметры, которые определяют силу и направление связи между искусственными нейронами и напрямую влияют на то, насколько сильно сигнал от одного нейрона воздействует на следующий. Простыми словами, веса — это то, что делает ИИ «умным». Каждый раз, когда сигнал проходит от одного нейрона к другому, он умножается на соответствующий вес. Если вес большой и положительный, сигнал усиливается, если маленький или отрицательный — ослабляется или даже подавляется. В итоге на выходе сети мы получаем результат, который зависит от миллионов таких маленьких умножений. Представьте оркестр: каждый музыкант — нейрон, играет свою ноту — сигнал, но дирижер заранее настроил громкость каждого инструмента — веса. Если скрипки слишком громкие, а контрабас едва слышен, звучание будет одним, а если поменять громкость — совсем другим. Обучение и есть такая настройка громкости миллионов инструментов, чтобы в итоге оркестр сыграл нужную мелодию — дал правильный ответ. Интересный факт: в современных больших моделях вроде GPT-4 или Llama количество весов исчисляется сотнями миллиардов. Каждый вес — это обычно число с плавающей точкой (float16 или bfloat16), и все вместе они занимают сотни гигабайт памяти. Именно эти веса и есть «знания» модели: если взять обученную сеть и обнулить все веса, она мгновенно забудет все, чему научилась. Без правильно настроенных весов ИИ был бы просто набором бесполезных математических операций. А с ними это инструмент, способный переводить тексты, генерировать картинки и решать задачи лучше человека в узких областях. По сути, веса — это и есть память и интеллект искусственной нейронной сети.Какие бывают слои?

Слои бывают трех основных типов: входные, скрытые и выходные. Входной слой просто принимает сырые данные: пиксели изображения, слова в тексте или числовые признаки, и передает их дальше. Выходной слой выдает финальный результат:- класс объекта на фото;

- следующее слово в предложении;

- или вероятность события.

- Полносвязные, или классика. Каждый нейрон одного слоя соединен со всеми нейронами следующего. Они универсальны, хорошо работают с табличными данными или когда признаки уже извлечены. Именно такие слои обычно стоят в конце сети, чтобы собрать всю информацию и выдать окончательное решение.

- Сверточные — «короли» компьютерного зрения. Они используют маленькие фильтры, которые «скользят» по изображению, выделяя локальные паттерны: края, текстуры, углы. Благодаря параметрам (один фильтр применяется ко всему изображению) и пулингу (уменьшению размерности) такие слои требуют меньше памяти и отлично находят пространственные закономерности. Без них не было бы современных систем распознавания лиц, объектов и медицинской диагностики по снимкам.

- Рекуррентные — созданные для последовательностей: текст, речь, временные ряды. Они имеют «память» — скрытое состояние передается от одного шага к следующему, позволяя учитывать контекст. Они решают проблему исчезающего градиента и лучше запоминают долгосрочные зависимости. Их часто заменяют трансформеры, но в некоторых задачах рекуррентные слои все еще актуальны.

- Слои внимания и трансформерные — основа современных больших языковых моделей. Механизм позволяет сети «смотреть» на все элементы последовательности одновременно и решать, какие из них важнее в данный момент. Это дало взрывной рост в обработке текста, переводах и генерации.

- Пулинг — не вычислительные слои, а уменьшающие размерность. Используются после сверточных слоев для снижения вычислительной нагрузки и повышения устойчивости к небольшим сдвигам.

- Нормализация — ускорение обучения и стабилизация процессов внутри слоя.

- Dropout — не слой в полном смысле, но часто вставляется между слоями. Dropout случайно «выключает» часть нейронов на время обучения, чтобы сеть не переобучалась.

Какие методы используются в обучении нейросети?

В обучении используются разные методы, которые определяют, как именно модель получает информацию о том, правильно ли она работает, и как корректирует свои внутренние параметры. По сути, это способы организовать процесс обучения, чтобы сеть могла решать конкретные задачи — от простого распознавания объектов до сложных стратегий в играх или генерации текста. Выбор метода зависит от нескольких факторов.- Есть ли у нас размеченные данные с готовыми правильными ответами.

- Нужно ли модели самостоятельно искать паттерны в огромных объемах информации.

- Или она должна учиться через пробы и ошибки, взаимодействуя с окружающей средой.

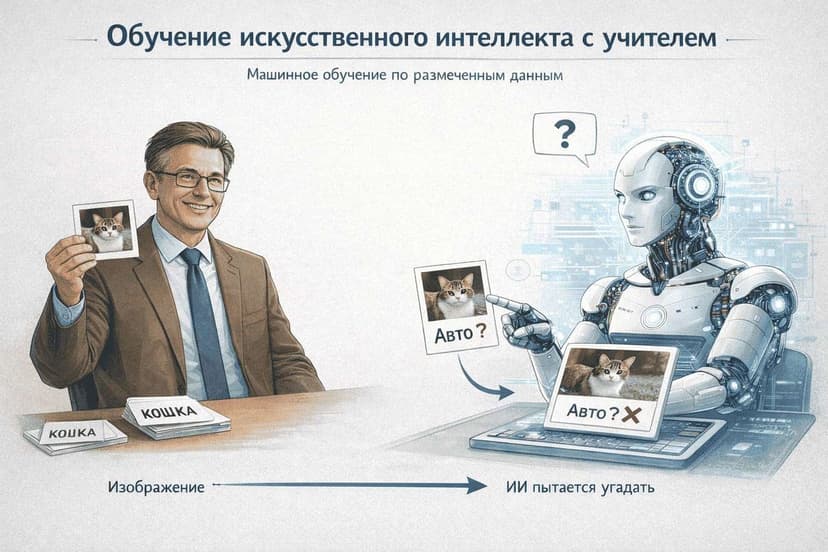

Обучение с учителем

Обучение с учителем — это самый распространенный и интуитивно понятный метод тренировки. Его суть в том, что модели показывают огромное количество примеров, где для каждого входа заранее известен правильный ответ, или метка. Представьте себе учителя, который показывает ученику карточки: на одной стороне картинка кошки, на другой надпись «кошка». Ученик пытается угадать, учителя поправляет, если ошибка, и со временем ученик начинает безошибочно определять кошек. Точно так же работает и ИИ:- она получает пару «вход и правильный выход»;

- делает свое предсказание;

- сравнивает его с меткой;

- вычисляет ошибку;

- и через обратное распространение корректирует веса, чтобы в следующий раз ошибиться меньше.

Размеченные данные — главный ресурс. Это могут быть фотографии с подписями объектов, тексты с правильным переводом, медицинские снимки с диагнозом врача, записи цен акций с известным будущим значением. Разметка обычно делается людьми, поэтому для больших датасетов это дорого и трудозатратно. Задачи, где этот метод идеален:

- классификация — определить, что на изображении: кошка, собака или птица; спам или не спам в письме;

- регрессия — предсказать непрерывное значение: цену квартиры, температуру завтра, рейтинг фильма;

- распознавание речи, машинный перевод, оптическое распознавание символов.

- нужны миллионы размеченных примеров;

- разметка может содержать человеческие ошибки или предвзятость;

- модель хорошо работает только в пределах того, что видела в обучении, если данные изменились, например, новые породы собак, точность может резко упасть.

Обучение без учителя

Обучение без учителя — подход, при котором ИИ работает с данными, где нет никаких меток или правильных ответов. Модели самой приходится искать скрытые закономерности, структуры и связи в «сыром» потоке информации, без подсказок от человека. Представьте себе археолога, который раскапывает древний город без карты. Он видит руины, артефакты, расположение построек и постепенно понимает, где был рынок, где храмы, где жилые кварталы. ИИ делает примерно то же самое: анализирует огромные объемы данных и самостоятельно выделяет паттерны, которые человеку даже в голову не пришли бы. Рассмотрим основные задачи, которые решает этот метод.- Кластеризация — группировка похожих объектов. Например, разделение клиентов магазина на сегменты по поведению: «любители скидок», «покупатели премиум-товаров», «редкие посетители».

- Снижение размерности — упрощение данных без потери важной информации. Это полезно для визуализации многомерных данных или ускорения дальнейшего обучения.

- Обнаружение аномалий — поиск редких, выбивающихся объектов. В банковских транзакциях это может быть мошенничество, в производстве брак на конвейере, в медицине редкие симптомы.

- результат менее предсказуем;

- нет прямой метрики «правильно/неправильно», поэтому сложно понять, насколько хорошо модель справилась;

- оценка качества часто субъективна или требует косвенных методов.

Обучение с подкреплением

Обучение с подкреплением — это подход, при котором или агент учится принимать решения через прямое взаимодействие с окружающей средой. Она пробует разные действия, получает за них награду — положительную или отрицательную — и постепенно учится стратегии, которая максимизирует суммарное вознаграждение в долгосрочной перспективе.Самая точная аналогия — дрессировка собаки: вы не говорите ей заранее «сделай именно так», а просто хвалите за правильное поведение и ругаете или игнорируете за неправильное. Со временем собака понимает, какие действия приводят к вкусняшке чаще всего. Точно так же агент не имеет размеченных данных с «правильными ответами». Он сам исследует мир, пробует и ошибается.

Ключевые компоненты этого метода:

- агент — сам ИИ, который принимает решения;

- среда — все, с чем агент взаимодействует (игра, физический мир робота, рынок акций, трафик в симуляторе);

- действие — выбор агента в текущий момент (повернуть налево, прыгнуть, купить акцию);

- состояние — текущая ситуация, которую видит агент (позиция на игровом поле, показания датчиков робота);

- награда — числовой сигнал от среды после действия (+10 за съеденный фрукт, — 1 за каждый шаг, — 100 за падение в пропасть);

- политика — стратегия агента: что делать в каждом состоянии.

- игровая индустрия;

- робототехника (обучение ходьбе, хватанию объектов, полетам дронов);

- автономное вождение и управление трафиком;

- оптимизация энергопотребления, рекламы, торговых стратегий;

- чат-боты последнего поколения.

- обучение очень нестабильно (агент может долго «блуждать» без прогресса);

- требует огромного количества попыток (миллионы часов симуляции);

- сложно настроить систему наград, чтобы не получить нежелательное поведение.

Гибридное обучение

Гибридное обучение — это подход, при котором сочетаются несколько разных методов тренировки, чтобы взять лучшее от каждого и добиться результатов, недоступных при использовании только одного способа. По сути, это комбинация инструментов под конкретную задачу, когда один метод готовит почву, а другой доводит модель до совершенства. На практике гибридные схемы встречаются повсеместно, потому что чистые подходы редко идеальны: один метод требует слишком много меток, другой не дает точного контроля, работает слишком нестабильно и ресурсоемко. Смешивая их, инженеры решают эти проблемы. Для понимания рассмотрим самые распространенные варианты комбинаций.- Без учителя + с учителем. Сначала модель работает без учителя на огромном объеме неразмеченных данных, что дает хорошее общее представление о мире. Потом сеть дообучается с учителем на небольшом, но качественно размеченном датасете под конкретную задачу.

- Обучение с учителем, где метки создаются автоматически из самих данных (маскируем слова и учим предсказывать их, закрашиваем часть изображения и учим восстановить).

- Обучение с подкреплением и учителем. Сначала модель работает с учителем на демонстрациях, чтобы быстро освоить базовое поведение. Потом агент получает награду за результат лучше, чем у человека. Пример — автономное вождение: сначала сеть копирует действия водителей-людей из видео, потом помогает оптимизировать траекторию, экономию топлива или безопасность.

- Обучение с подкреплением и обратной связью. Модель сначала предобучается, потом люди оценивают ее ответы, из этих предпочтений строится модель награды, и наконец подкрепление настраивает основную модель так, чтобы она чаще давала ответы, которые нравятся людям.

- Мультизадачное обучение — сеть одновременно решает несколько задач с разными типами обучения (например, классификация + генерация + кластеризация), что помогает ей лучше обобщать.

Алгоритмы оптимизации

Алгоритмы оптимизации — это сердце процесса обучения. Их задача — эффективно обновлять миллионы, а иногда и миллиарды весов так, чтобы функция потерь — мера ошибки модели — уменьшалась как можно быстрее и стабильнее. Без хорошего оптимизатора даже идеальная архитектура может учиться годами или застревать в плохих решениях. Представьте себе спуск с горы в густом тумане. Функция потерь — это высота ландшафта, а веса — ваши координаты. Цель — найти самую низкую точку — глобальный минимум. Но поверхность полна холмов, плато и ложбинок, поэтому простой подход «иди всегда вниз по склону» не всегда работает оптимально. Выбор оптимизатора влияет не только на скорость, но и на финальное качество модели. Понимание этих алгоритмов помогает не только ускорить обучение, но и избежать типичных проблем — застревания на плато, расхождения или слишком медленной сходимости. В современном глубоком обучении хороший оптимизатор — половина успеха.Обучаем нейросеть шаг за шагом

Давайте разберем на конкретном примере обучение модели для распознавания рукописных цифр.- Подготовка данных. Собираем тысячи изображений цифр от 0 до 9, размеченных правильными ответами. Делим на тренировочную, валидационную и тестовую выборки.

- Инициализация модели. Создаем сеть с входным слоем, несколькими скрытыми и выходным.

- Прямое распространение. Изображение подается на вход, проходит слои: каждый нейрон суммирует взвешенные сигналы, применяет активацию.

- Вычисление ошибки. Сравниваем предсказание с меткой через функцию потерь.

- Обратное распространение. Градиенты ошибки распространяются назад, вычисляя вклад каждого веса.

- Обновление весов. Оптимизатор корректирует веса.

- Итерации. Повторяем тысячи раз, мониторя точность на валидации.

- Тестирование. Проверяем на новых данных — хорошая модель достигает 98–99% точности.

Где не обойтись без глубокого обучения?

Глубокое обучение незаменимо в сферах с большими данными и сложными паттернами. Перечислю примеры для лучшего понимания вопроса.- Компьютерное зрение: распознавание объектов, лиц, медицинские изображения.

- Обработка естественного языка: переводы, чат-боты, генерация текста.

- Автономный транспорт: анализ дороги в реальном времени.

Наука и этика

Развитие искусственного интеллекта идет семимильными шагами, но вместе с мощью приходят и серьезные этические вызовы. Наука дает нам инструменты, способные решать задачи лучше человека, но без осознанного подхода эти инструменты могут причинить вред обществу. Один из главных вопросов — предвзятость моделей. ИИ учатся на данных, созданных людьми, а эти данные часто отражают исторические несправедливости. Например, если в датасете для распознавания лиц больше светлокожих людей, модель хуже работает на темнокожих — реальные случаи были с системами рекрутинга Amazon и судебного прогнозирования COMPAS в США. Предвзятость может усиливать дискриминацию по расе, полу, возрасту или социальному статусу. Второй серьезный аспект — потеря рабочих мест. Автоматизация рутинных задач уже затронула профессии водителей, операторов кол-центров, переводчиков, журналистов начального уровня и даже радиологов. При этом новые профессии появляются медленнее, и не все работники могут быстро переучиться. Конфиденциальность и безопасность данных — еще одна острая тема. Обучение больших моделей требует гигантских объемов информации, часто собранной из интернета без явного согласия авторов. Модели могут «запоминать» личные данные: были случаи, когда ChatGPT воспроизводил фрагменты приватных медицинских записей или конфиденциальных чатов. Плюс риск злоупотребления:- дипфейки;

- автоматизированное мошенничество;

- оружие на базе ИИ.

Ученье — свет: будущее Deep Learning

Deep learning интегрируется глубже: мультимодальные модели, агенты ИИ, эффективные вычисления. Появятся сверхразумные системы, но с фокусом на этику и доступность.

Комментарии к статье

Пока нет комментариев. Будьте первым!